LLMs : solutionneurs de problèmes GitHub ?

Les modèles linguistiques peuvent-ils résoudre de vrais problèmes GitHub ? 🤔

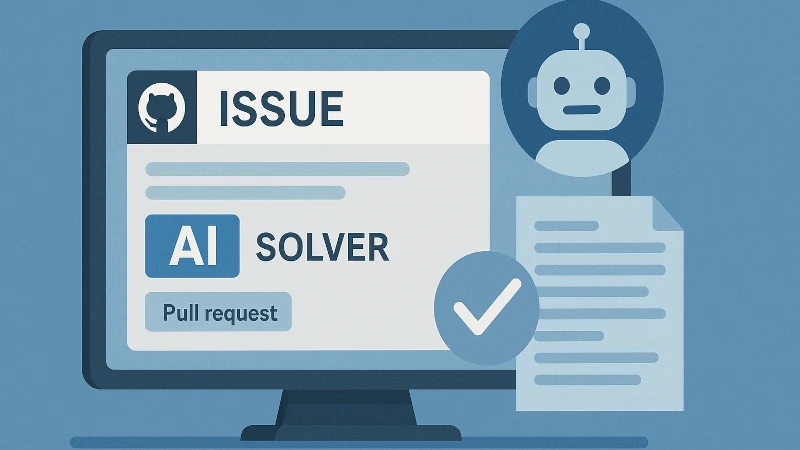

Je viens de découvrir SWE-bench, un benchmark fascinant qui évalue les modèles d’IA sur leur capacité à résoudre de vrais problèmes issus de GitHub. Développé par des chercheurs de Princeton et de l’Université de Chicago, SWE-bench est une plateforme complète pour tester l’intelligence artificielle en ingénierie logicielle.

Qu’est-ce que SWE-bench ?

SWE-bench regroupe 2 294 problèmes tirés de véritables issues GitHub et des pull requests correspondantes, issus de 12 dépôts Python populaires. Chaque tâche demande à un modèle linguistique de modifier le code source pour corriger une issue donnée, impliquant souvent plusieurs fichiers et fonctions.

Performance des modèles d’IA

Lors de son lancement, même les meilleurs modèles comme Claude 2 n’atteignaient qu’un taux de réussite de 1,96 %. Aujourd’hui, des progrès notables ont été réalisés. Par exemple, Claude 3.7 Sonnet atteint 33,83 % de succès sur le benchmark complet.

OpenAI a également participé à la création de SWE-bench Verified : un sous-ensemble de 500 cas soigneusement vérifiés. Cette version améliore la clarté des descriptions et réduit les problèmes liés aux tests trop spécifiques.

Pourquoi c’est important

SWE-bench offre un environnement réaliste et exigeant pour évaluer les capacités pratiques de codage des modèles IA. Contrairement aux benchmarks classiques, il exige une compréhension globale et des modifications à grande échelle dans le code.

Pour les passionnés d’IA et de développement, SWE-bench est une ressource précieuse pour explorer les forces et les limites actuelles des IA en ingénierie logicielle.

Hashtags : #IA #ingénierielogicielle #apprentissageautomatique #GitHub #Benchmarking