LLMs Conseguem Resolver Problemas do GitHub?

Modelos de Linguagem Conseguem Resolver Problemas Reais do GitHub? 🤔

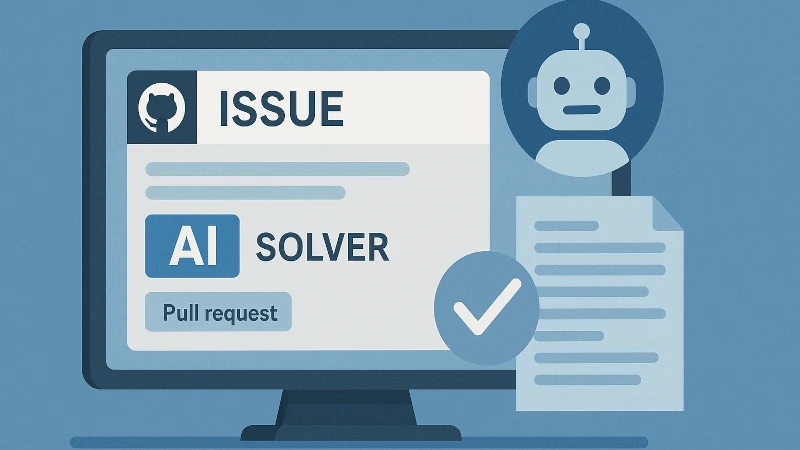

Acabei de descobrir o SWE-bench, um benchmark fascinante que avalia modelos de IA na resolução de problemas reais extraídos de issues do GitHub. Desenvolvido por pesquisadores de Princeton e da Universidade de Chicago, o SWE-bench é um campo de testes completo para avaliar a IA na engenharia de software.

O que é o SWE-bench?

O SWE-bench inclui 2.294 problemas reais de engenharia de software, retirados de issues e pull requests de 12 repositórios populares em Python. Cada tarefa exige que o modelo modifique o código-fonte para resolver uma issue, muitas vezes alterando múltiplas funções e arquivos.

Desempenho dos Modelos de IA

No início, modelos avançados como o Claude 2 resolviam apenas cerca de 1,96% dos casos. Mas os avanços são notáveis: o modelo Claude 3.7 Sonnet já atinge 33,83% de sucesso no benchmark completo.

A OpenAI também colaborou com os autores para lançar o SWE-bench Verified—um subconjunto com 500 exemplos revisados para maior clareza e qualidade. Esse refinamento corrige problemas como testes muito específicos ou descrições vagas.

Por que isso importa?

O SWE-bench fornece um ambiente realista e desafiador para testar as habilidades práticas de programação dos modelos de IA. Diferente de benchmarks simples, ele exige entendimento profundo e alterações amplas em sistemas reais.

Para entusiastas de IA e desenvolvedores, o SWE-bench é uma excelente fonte para explorar o que a IA consegue (ou ainda não consegue) fazer na engenharia de software.

Hashtags: #IA #engenhariadesoftware #aprendizadoautomático #GitHub #Benchmarking